第3弾

雨宮リカの誕生はまさかの妹の結花だったとは。

リバースってreverseじゃなくrebirthだった。

『リバース』ー五十嵐貴之

『リターン』ー五十嵐貴之

第2弾

最後にリカは死んだと思われるが、梅本刑事にその歪んだ愛がもしかして伝染したのでは?と感じられる結末。

『リカ』ー五十嵐貴久

リカがどういう収入で暮らしているのかが謎だか、こんな狂気に満ちた女は恐ろしい。

最後の結末もビックリ(^_^;)

次回作へ続く…

午後の珈琲

午後はブラジル

今朝の珈琲

今朝の珈琲は、エルサドバトル。

福岡のレックコーヒーより。

若干酸味があるかな?

『鵜頭川村事件』-櫛木理宇

もっとぞくぞくする内容かと思ってたが、

全然期待外れ。

『赤い砂』-伊岡瞬

結構感染症をテーマにした作品が多いんですね。

『代償』-伊岡瞬

これは惨い!

こんな奴がいるなんて・・・

とにかく面白い!

『本性』-伊岡瞬

これは面白い!

最恐の女!

是非読んでみるべき!

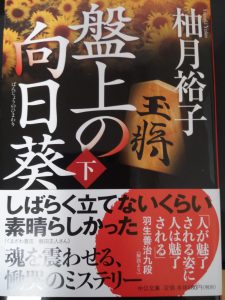

『盤上の向日葵』-柚月裕子

文句なく面白かった。

読んでみる価値あり!